Kurzbeschreibung

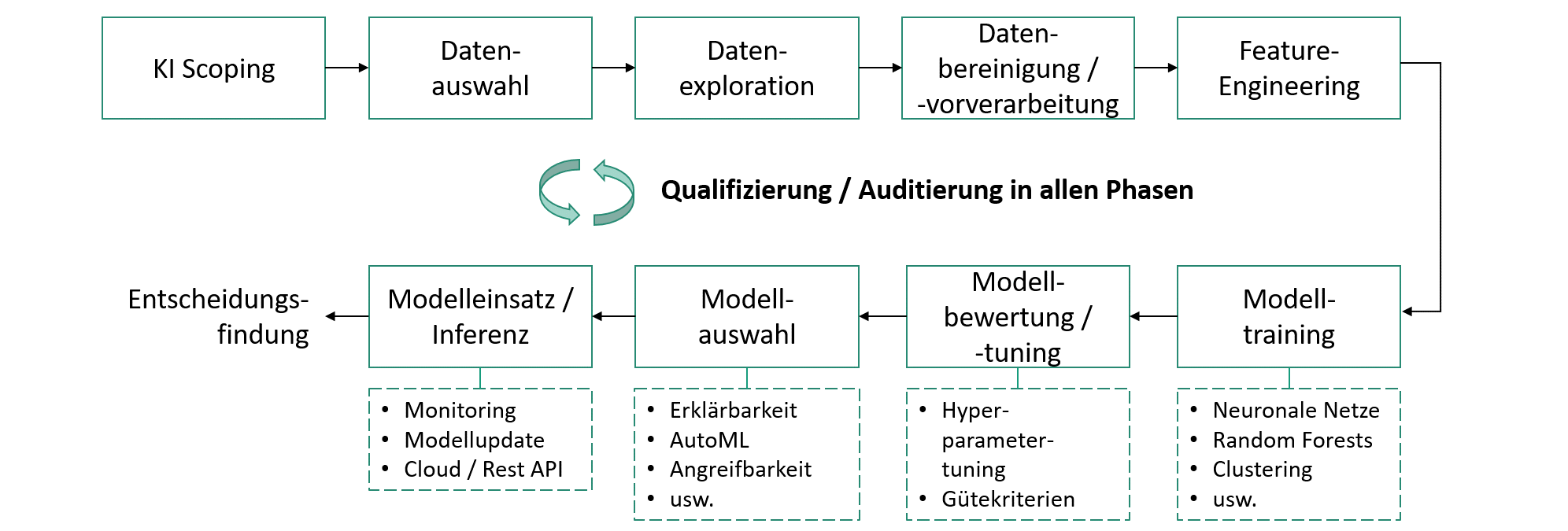

Bei kleinen und mittelständischen Unternehmen (KMU) ist der manuelle Anteil bei der Qualitätsprüfung in der industriellen Produktion sehr hoch. Durch den Einsatz von Künstlicher Intelligenz (KI) versprechen sich die Unternehmen eine Automatisierung der Qualitätsprüfung und wirtschaftliche Vorteile. Dabei rücken Methoden des maschinellen Lernens (ML) wie etwa künstliche neuronale Netze in den Vordergrund. Diese versprechen eine hohe Leistungsfähigkeit und werden vollständig auf Daten trainiert; ohne Vorgabe von expliziten, menschgemachten Regeln. Allerdings ist es gerade die selbstlernende Eigenschaft, welche bei den Unternehmen zu Bedenken hinsichtlich Zuverlässigkeit oder Akzeptanz führt sowie die Bewertung von ML-Methoden erschwert, ganz im Gegensatz zu herkömmlicher Software und regelbasierten KI-Sytemen. Zudem fehlen bei KMU vielfach die personellen Ressourcen und Fachkenntnisse, um die Eignung von fremdbezogenen KI-Systemen zu prüfen. Ziel des Projekts ist daher die Entwicklung eines Software-Frameworks für die vereinfachte Qualifizierung bzw. Auditierung von ML-basierten KI-Systemen in der industriellen Qualitätsprüfung. Das Framework besteht aus einem Vorgehensmodell samt software-gestützter Methoden und Werkzeuge. Da bei der Entwicklung von KI-Systemen mehrere Phasen durchlaufen und in jeder Phase Entwicklungsentscheidungen mit Einfluss auf das Ergebnis getroffen werden, umfasst die Qualifizierung sämtliche Phasen. Dazu unterstützt das Framework bei der Ermittlung und Formulierung von Prüf- und Bewertungskriterien entlang aller Phasen. Diese Kriterien werden in einer sogenannten Argumentationsstruktur erfasst, welche vom Framework zur Unterstützung der Auditierung des KI-System genutzt wird. Das Framework ist modular gestaltet, so dass eine einfache Integration und Erweiterung von Prüf- bzw. Auditierungsmodulen möglich wird. Mit dem Framework sollen insbesondere KMU dazu befähigt werden, auch ohne eigene KI-Fachkräfte die Leistungsfähigkeit von KI-Systemen bewerten zu können.

Framework zur Qualifizierung von KI-Systemen in der industriellen Qualitätsprüfung (AIQualify)

Framework zur Qualifizierung von KI-Systemen in der industriellen Qualitätsprüfung (AIQualify)